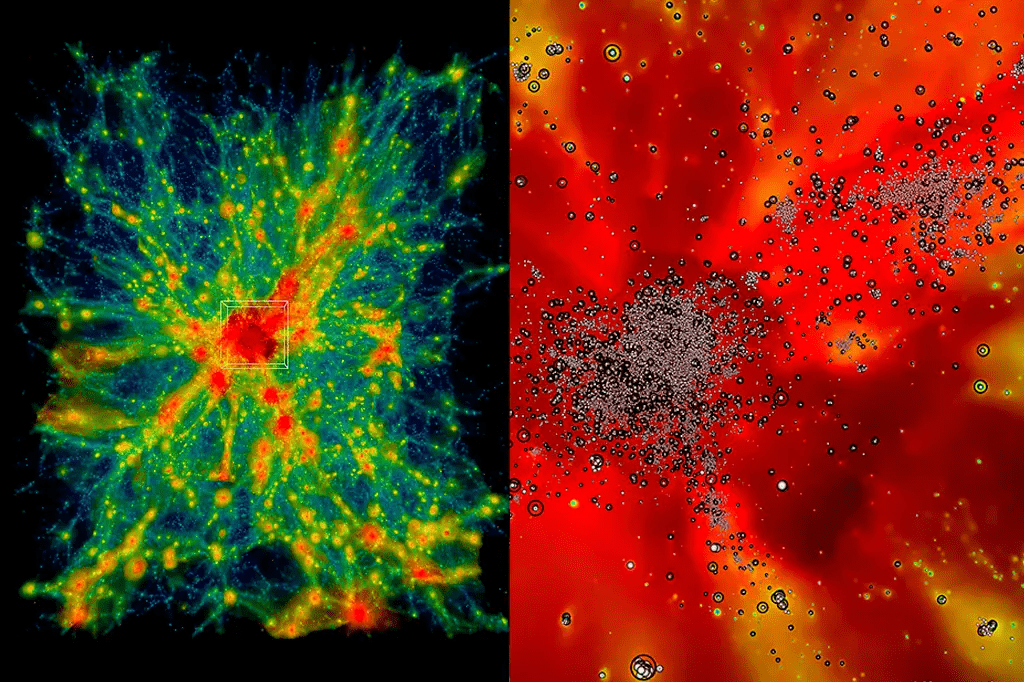

No começo de novembro, um grupo de pesquisadores do Laboratório Nacional de Argonne, nos EUA, usou o mais potente supercomputador do mundo, batizado de Frontier, para recriar a história do Universo em um grau de detalhe inédito.

O software simula com precisão altíssima a expansão do cosmos nos últimos 13,8 bilhões de anos. Além de incluir o tecido do espaço-tempo em si – que é o cenário onde todo o resto se apoia –, ele considera os gases hidrogênio e hélio em altas temperaturas (que eram basicamente tudo que existia na primeira infância do cosmos), a formação de estrelas e a aglomeração desses astros em galáxias ancoradas por buracos negros.

A maior parte das simulações feitas hoje considera apenas o espaço-tempo em si, ou seja: o jogo de forças gravitacionais que está por trás da formação dos sistemas estelares, das galáxias e da expansão do Universo como um todo.

Acontece que o espaço-tempo é “só” o cenário da realidade e a maneira como ele se curva de acordo com as equações da Relatividade Geral de Einstein. Uma simulação completa precisa levar em consideração também o recheio. A matéria e a energia.

“Se nós quisermos saber o que vai acontecer com o Universo, precisamos simular a gravidade e também as outras coisas, que incluem gases quentes e a formação de estrelas, buracos negros e galáxias”, disse em declaração à imprensa Salman Habib, diretor da divisão de ciências da computação em Argonne. “Essas simulações são o que chamamos de simulações de hidrodinâmica cosmológica“.

O objetivo é comparar a simulação com os levantamentos do Universo de verdade, realizados por telescópios com grande alcance e definição, cujas observações abarcam fatias enormes da abóbada celeste e, portanto, uma quantidade muito grande de astros.

Conforme esses levantamentos se tornam mais abrangentes e detalhados, o poder computacional necessário para simular o cosmos e seu recheio precisa crescer para acompanhá-los.

A comparação entre simulações e a vida real é essencial para fazer ajustes-finos na matemática que descreve a realidade e chegar a novos insights sobre a origem e a evolução do Universo.

O software de supercomputador usado na simulação é chamado HACC, abreviação de Hardware/Hybrid Accelerated Cosmology Code.

Ele foi desenvolvido há cerca de 15 anos para máquinas que fazem operações na ordem de grandeza dos petabytes, que fazem até um quadrilhão de operações (FLOPS, no jargão da área) por segundo. Em 2012 e 2013, o HACC foi finalista do Prêmio Gordon Bell de computação da Associação para Maquinário de Computação.

Para a aplicação atual, esse código passou por modificações e agora roda em máquinas que operam na escala dos exabytes, três ordens de grandeza acima. Esse é o caso do supercomputador Frontier, que usa chips da Nvidia chamadas GPUs, os mesmos responsáveis por sustentar o boom recente na inteligência artificial.

“A computação na escala dos exabytes não permite só dar conta do mero tamanho do domínio físico, que é necessário para fazer uma comparação direta com as observações de levantamentos astronômicos atuais”, explica Bronson Messer do Laboratório Nacional de Oak Ridge, onde fica instalado o Frontier.

“Também há o realismo adicional de incluir os bárions [ou seja, a matéria comum, que perfaz os átomos] que torna essa simulação um desafio para o Frontier.”

Luz P’ra Nós!

A ciência deu mais um passo impressionante! Imagine o impacto que descobertas como essas podem ter nas próximas décadas!

Luz p’ra nós!

Luz p’ra nós 🙏🏻

#luzpranos

Luz p’ra nós!

Simulações de hidrodinâmica cósmica, tecidos do espaço tempo, forças gravitacionais que impulsionam a expansão do universo, simulações da hidrodinâmica cósmica, levantamentos astronômicos na escala de exabytes. Bastante informação para Frontier contar a história do universo. LPN ✨🙏

Luz pra nós 🙏

Luz p’ra nós

Luz p’ra nós

Luz pra nós.

Luz p’ra nós!

Luz p´ra nós!

Muito interessante, com toda essa potência e informações combinadas, vai ter muitos avanços nessa área, Luz p’ra nós!

Obrigada pelo post!!! Luz pra nós!