O Google já vinha dando pistas de que o principal recurso do Android seria o Gemini e a sua IA. Durante o evento Made by Google, a companhia divulgou novos recursos e maneiras de utilizar a ferramenta nos telefones celulares.

Durante a apresentação, o Google reforçou que vem construindo um sistema operacional com Inteligência Artificial no seu núcleo. Os novos recursos do Gemini no Android incluem, por exemplo, a capacidade de ter uma conversa mais natural com o utilizador. Essa ferramenta se chama Gemini Live.

A companhia cita que remodelou a experiência de usar o assistente Gemini. Agora, ele traz uma conversa mais natural, como se você estivesse pedindo coisas a outro ser humano. A empresa também demonstrou algumas vozes diferentes, como uma mais animada, uma mais calma ou uma mais clara, que facilita a compreensão das palavras.

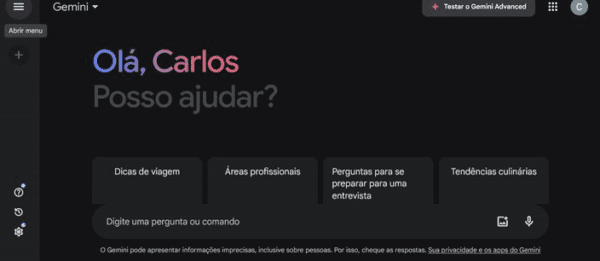

O Google Gemini é o concorrente do ChatGPT. (Imagem: Carlos Palmeira/TecMundo)

O Google Gemini é o concorrente do ChatGPT. (Imagem: Carlos Palmeira/TecMundo)

A ideia do Gemini Live é, de fato, ter conversas mais diretas com o assistente do Google. A companhia cita, como exemplo, que você pode praticar para uma entrevista de emprego, para achar uma ideia melhor de presente e mais. Você pode explorar ideias, fazer perguntas complexas e afins.

De acordo com o Google, o Gemini Live tem seu lançamento no Android, mas só em inglês, até o momento. Para testar o novo assistente que “fala como um ser humano”, é preciso ser assinante do plano Gemini Advanced. O Google ainda disse que nas próximas semanas, lançará mais idiomas para a funcionalidade.

Gemini pode ler a tela do seu celular Android

Outra novidade do Android e do Gemini é a habilidade de “ler” a tela dos celulares e tomar ações. Por exemplo, você pode acionar o assistente enquanto assiste a um vídeo do YT, e então ele achará respostas sem interromper a reprodução.

O Google também cita que agora está mais fácil gerar imagens com o Gemini e depois copiar e colar nos seus aplicativos — como de e-mail ou de mensagens.

Em uma demonstração, a companhia mostra um rascunho de e-mail com uma ideia de bolo para uma festa de aniversário. Então, o Gemini é acionado e gera algumas imagens para que o utilizador apenas selecione a que quiser e arraste para o app que quer enviar.

Essa exibição do Gemini acontece como um pop-up, sem necessariamente abrir o aplicativo completo do assistente. Ou seja, o uso da ferramenta deve, cada vez mais, acontecer “por cima” de outros aplicativos.

Em um outro exemplo, o Google demonstra o uso do Gemini com a câmera. Um usuário aponta o celular para um cartaz com datas anunciadas de shows do seu artista preferido, e então pede ao assistente para conferir se estará livre no dia que ele for se apresentar.

Por causa da integração com o Workspace, ele pode acessar informações da Agenda e criar lembretes para “checar os preços” do ingresso — tudo baseado no mesmo contexto da imagem enviada. A companhia também demonstra a capacidade do Gemini de realizar ações paralelas, como adicionar um item à lista de compras no Keep, enquanto faz outra ação.

Gemini nos tablets

Durante o evento, o Google também revelou que o Gemini será oficialmente lançado para tablets Android “ainda nesta semana”.

A companhia reforçou que o assistente foca na escalabilidade para entregar recursos de Inteligência Artificial, mas que também mistura o poder de computação em nuvem com o local, dos próprios dispositivos.

Assim como na nova linha Pixel 9, ele funciona localmente com base no modelo de linguagem Gemini Nano.

Fonte: tecmundo.com.br

Portais:

Luz p’ra nós✝️

Ajudem compartilhando|comentando

Luz p’ra nós 🙏🏾⚛️✅

Caraca, isso vai ser louco, luz p’ra nós 🙏

Luz p’ra nós!

Luz pra nós.

Show,IA é sempre bem vinda!

Muito bom! Esses recursos podem ser muito úteis para tornar o uso do celular mais fluido e prático no dia dia.

Luz p’ra nós!

Luz p’ra nós

Luz p’ra nós 🙏🏻

#luzpranos

Luz p’ra nós!

Luz p’ra nós 🙏🏻